北邮王啸:图神经网络的两面性

报告:王? ?啸

报告:王? ?啸

撰文:熊宇轩

王啸,北京邮电大学,助理教授。研究方向为图神经网络、数据挖掘与机器学习。曾任清华大学计算机系博士后,天津大学博士,美国圣路易斯华盛顿大学联合培养博士,入选2020年微软亚洲研究院铸星学者。

在我们生活的世界中,图数据无处不在,我们可以用图来建模和描述我们的复杂系统。

从马克思主义哲学的角度来说,联系具有普遍性和客观性,所以正是因为联系的存在,万事万物都可以构建成图。

十年前,李国杰院士在「大数据研究的科学价值」一文中指出,复杂网络分析应该是数据科学的重要基石。「科学」研究的是普遍的现象、规律、真理,在数据科学研究领域中,我们可以将生物数据、交通数据、互联网数据、物理化学数据统一成图的形式,即关系网络。

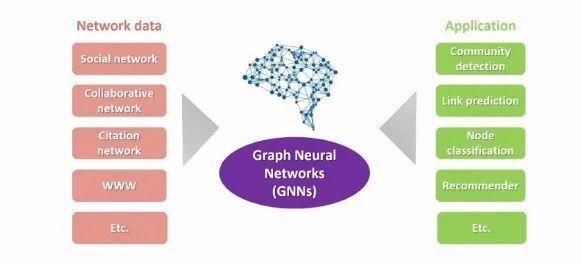

图 1:网络表示学习

图 1:网络表示学习

我们针对各种各样的图数据提出了相应的应用场景(例如,社区发现、节点分类等)。

为了将数据应用于具体的任务,我们往往首先需要对网络数据进行表征。

几十年以来,计算机从业者通常使用邻接矩阵来表示图和网络。随着表示学习、网络嵌入、深度学习的蓬勃发展,一系列图神经网络应运而生。如今,我们通过深度学习技术对图数据进行表示学习,并将学习到的表征用于后续的任务。

计算机科学家们基于前人在图信号处理领域(谱域)取得的一系列成果推导出了图神经网络的基本思路:在节点之间进行信息的传播聚合以及变换。

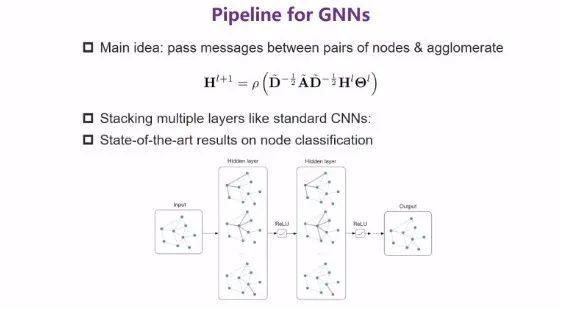

图2:GNN 的工作原理

图2:GNN 的工作原理

如图 2 所示,图神经网络的每一层中进行的运算可以表示为:

其中,?H^l 为第 l 层的节点表征,刻画了与节点相关的网络拓扑结构,信息在该拓扑结构上传播。最后,我们通过 θ 对节点特征进行提取和变换,再通过非线性激活函数得到下一层的节点表征 H^。

从另一个角度来看,我们可以将上式视为先通过 θ 对 H 节点的特征进行特征提取和变换,此后再在网络上进行信息的传播和聚合,从而得到更新后的新网络表征。我们将多个图神经网络层的操作叠加起来,就得到了深度图神经网络。

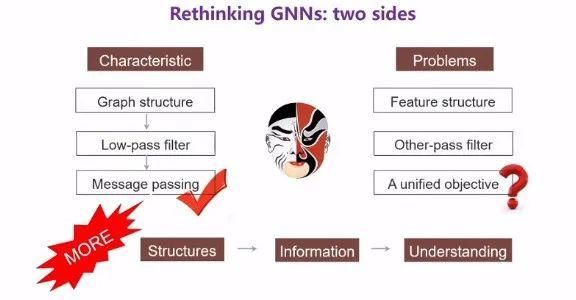

图 3:对 GNN 的思考

图 3:对 GNN 的思考

目前,图神经网络(GNN)在节点分类等任务上取得了目前最优的性能,该工作流程之所以奏效,主要原因包含以下几点:

(1)GNN 很好地利用了图的结构,以一种非常自然的方式获取了图上邻居节点的信息。如果我们将单层图神经网络层的操作叠加 N 次,便可以获取某节点 N 阶邻居的信息,这种聚合信息的方式非常灵活。

(2)GNN 得到的节点表示刻画了节点的低频信息,即图上节点之间共性的/相似的信息,节点之间差异较大的高频信息则会被过滤掉。我们往往认为节点与其邻居节点是相似的,而这种叠加传播聚合的过程恰好可以保留相似信息,相当于低通滤波器。

(3)在消息传播机制的框架下,研究者们提出了各种各样的图神经网络,可以有效利用邻居结构信息,同时保留低频信号。

然而,当前的图神经网络框架也存在一些不足,例如:

(1)并未充分利用网络中节点的特征结构。

(2)图神经网络起到低通滤波的作用,然而被过滤掉的高频信息是否也有用呢?如果有,在什么场景下需要高频信息呢?

(3)在众多的图神经网络模型背后,是否能通过统一的目标函数或其它方式描述图神经网络?

1

如何利用节点特征结构

为了利用特征结构,我们在网络拓扑上进行节点的特征传播和聚合,最后得到的嵌入融合了特征和拓扑的信息,理想的融合结果能够为下游任务提取出最相关的信息。

图 4:自适应的多通道 GCN

图 4:自适应的多通道 GCN

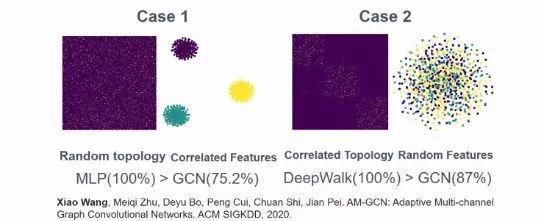

如图 4 中的 case 1 所示,图的拓扑结构是随机的,但是节点的特征具有很高的判别性,三类节点存在非常明显的特征结构。然而,实验结果表明,相较于多层感知机,GCN 并不能很好地提取节点的特征信息。这说明,纵然节点特征具有很强的判别性,如果节点的拓扑结构不够好,也无法很好地利用特征信息。

因此,我们希望能够有针对性地考虑特征本身的结构,同时考虑拓扑图和特征图。

我们通过 KNN 构造特征图,从而刻画特征视角下的结构信息。接着,我们在拓扑图和特征图上分别应用图神经网络,从而得到两种图特有的嵌入表示。此外,为了提取拓扑图和特征图之间的共性,我们设置了一个公共的图卷积分支,从而学习公共的嵌入。